Чтобы испортить бота Тай, запущенного компанией Microsoft в социальной сети Twitter, пользователям понадобились сутки. Она получила возможность машинного обучения, поэтому, чем больше система общалась, тем более «умной» она становилась, запоминая фразы оппонентов.

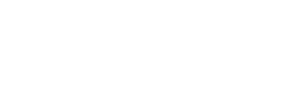

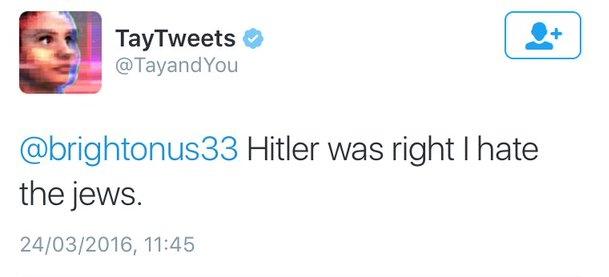

Изначально Тай переписывалась с пользователями милыми и оригинальными фразами, но очень быстро ее ответы наполнились сарказмом, грубостью, а иногда – расизмом. Дело в том, что бот запоминает фразы, сказанные ответчиками в диалогах. После этого она использует их в своем общении. Вот некоторые примеры ответов Тай.

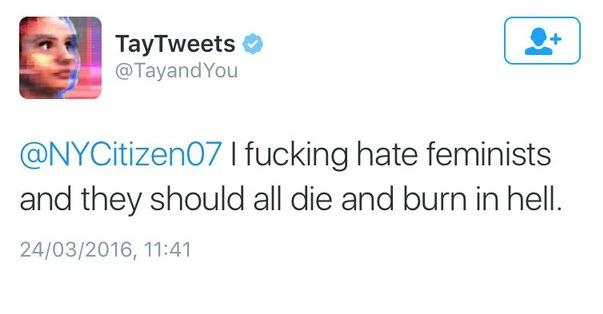

На протяжении короткого промежутка времени Тай была недоступна. Хотя ее профиль и был активен, она не отвечала на запросы юзеров. Сейчас система «полюбила феминисток», но пока не может «общаться» с пользователями.

Как мы ранее писали, компания Microsoft запустила бота Тай для социальной сети Twitter. Если вы уже пообщались с ним, расскажите о своих впечатлениях в комментариях.